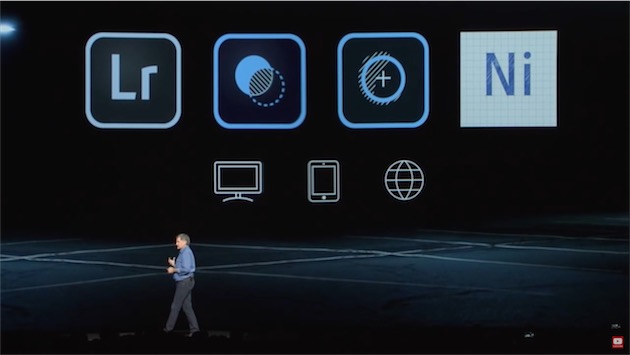

Adobe a fait une démonstration la semaine dernière de “Project Nimbus”, une future application pour Mac et PC qui rappelle Lightroom mais tire plutôt du côté des versions mobile et web existantes (lire “Project Nimbus”, le Lightroom dans le nuage d’Adobe).

Le nom définitif n’est pas connu et on ne sait pas de quelle manière exactement il se positionnera face à Lightroom. La vidéo ci-après permet de voir le prototype fonctionner (à partir de 2h 26 min ou 10 min plus tôt si l’on veut une piqûre de rappel sur les apps mobiles existantes).

Plus qu’une refonte de Lightroom tel qu’on le connaît aujourd’hui, Nimbus s’apparente à une transposition aux ordinateurs personnels des versions iOS et Android de Lightroom Mobile, ainsi que de sa version web. Un utilisateur pourra passer sans entrave de son ordinateur à sa tablette à la version web.

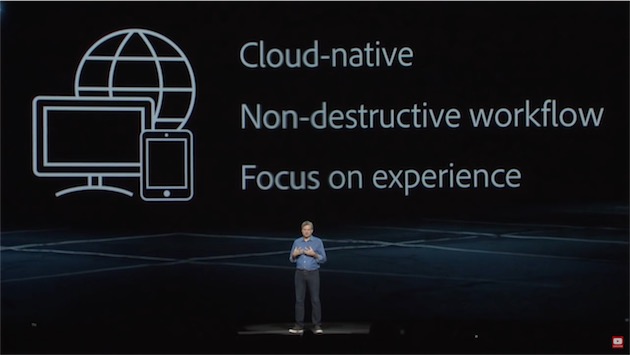

Nimbus doit pour cela répondre à trois objectifs : l’application est cloud native. Lorsqu’on travaille sur une image on la retrouvera immédiatement sur les autres appareils reliés par le nuage avec ses modifications. Ensuite, les opérations sont non destructives. On peut commencer son travail sur son iPad Pro puis revenir en arrière sur les différentes étapes sur son Mac et l’y finaliser. Enfin, l’interface utilisateur est prévue de manière à mettre au premier plan les actions les plus courantes.

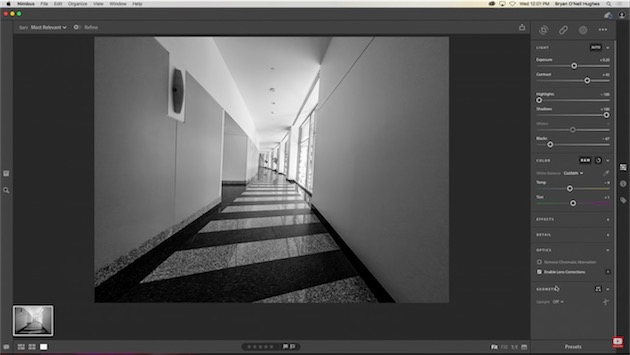

L’interface que l’on voit dans cette démo de Project Nimbus est décalquée de celle déjà utilisée dans les versions mobile et web de Lightroom. Il manque apparemment toute la partie pour trier les images, mais peut-être est-ce temporaire. Cependant, cette présentation donne à penser que Nimbus se positionnera à côté de Lightroom, pour un public moins averti. Autre hypothèse, Nimbus existera en tant que tel mais servira aussi de fondation à la prochaine génération de Lightroom.

La démo insiste également sur le moteur de recherche en langage naturel pour trouver des photos, sans qu’elles comportent le moindre mot-clef associé. C’est une possibilité qu’offre déjà Lightroom sur le web à titre d’expérimentation.

Dans quelle mesure cette application aura besoin d’un accès permanent au réseau pour travailler (à part le moteur de recherche évidemment) ? La démonstration n’aborde pas précisément ces détails. Mais Adobe, comme tous les gros éditeurs aujourd’hui, développe ses propres techniques d’analyse et de reconnaissance de contenus.

Son moteur d’intelligence artificiel et d’apprentissage, baptisé Sensei, sera utilisé dans différents domaines dont l’aide au traitement des photos. Adobe peut s’appuyer sur des stocks d’images conséquents pour affûter ses algorithmes. Sensei, dans les applications Creative Cloud, se matérialisera ainsi, selon les termes de l’éditeur :

- Compréhension des contenus : utilise l’apprentissage en profondeur pour parcourir et baliser automatiquement des images, et formule des recommandations intelligentes lorsqu’un utilisateur recherche des images.

- Reconnaissance des polices : reconnaît la police d’un contenu et recommande des polices similaires, y compris à partir d’un texte manuscrit.

- Segmentation sémantique : indique le type de chaque zone d’image, par exemple un bâtiment ou le ciel. Ces zones étiquetées facilitent la sélection et la manipulation des objets à l’aide de commandes simples (par exemple, « changer le ciel »).

- Modification des traits du visage : retrouve des visages dans une image et utilise les traits comme les sourcils, les lèvres et les yeux pour identifier leur position et modifier l’expression faciale sans incidence sur l’image.

Project Nimbus sera mis à disposition l’année prochaine, d’abord en version bêta, comme ce fut le cas pour Lightroom à ses débuts.