Le feuilleton des nouveautés qu'Apple prévoit d'annoncer lors de la WWDC 2019 se poursuit, avec des détails supplémentaires fournis par Guilherme Rambo.

Dans la catégorie Siri, les développeurs pourront offrir aux utilisateurs de leurs apps de nouvelles requêtes. Le rédacteur de 9to5mac cite plusieurs domaines d'actions ou d'apps qui pourront en profiter, tels que la lecture de contenus, la recherche, les appels vocaux, les billets achetés pour des événements, les pièces-jointes, les voyages en train, en avion, les portes d'aéroport et vos réservations de sièges.

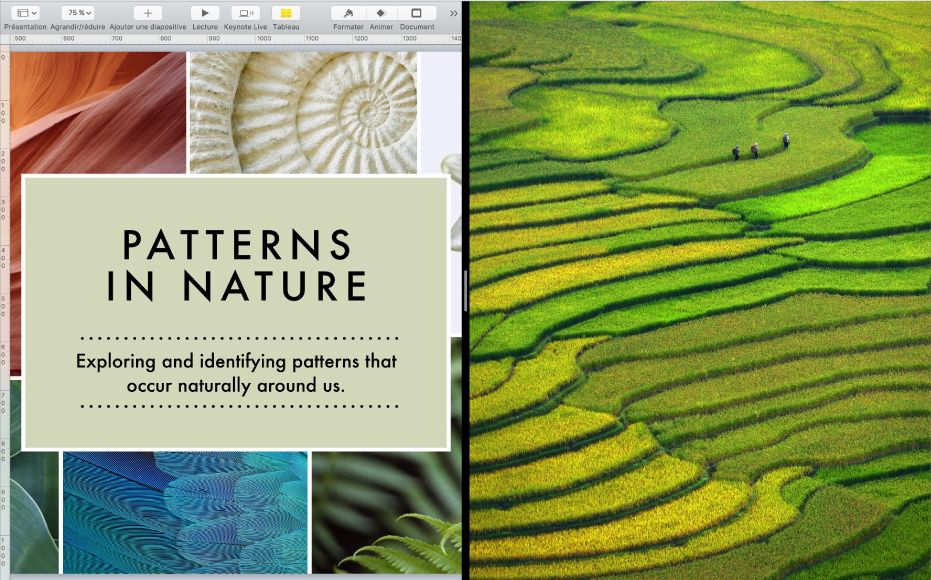

Dans le cadre de Marzipan, Rambo laisse entendre que les développeurs d'apps iOS auront des API pour exploiter la Touch Bar, la barre des menus et les raccourcis claviers. Ces apps venus d'iOS sauront également gérer plusieurs fenêtres distinctes. Autant de choses prévues pour rendre ces apps venues plus conformes à ce que l'on attend d'une utilisation sur macOS.

Les apps iOS compatibles Split View pourront être redimensionnées en jouant sur la barre de séparation et sa position pourra être remise à sa place de départ par un double-clic (en somme, ce que l'on fait déjà aujourd'hui dans macOS).

Quant à activer la compatibilité avec macOS pour une app iOS, ça passera par une simple case à cocher dans Xcode. À la manière de ce qui est fait pour une app iPhone que l'on veut faire tourner sur iPad (sans préjuger bien sûr d'autres adaptations et optimisations nécessaires aux particularités de chaque plateforme).

Pour la réalité augmentée (RA), Rambo écrit qu'un framework dédié, écrit en Swift sera offert ainsi qu'une app pour créer visuellement des expérience de RA. ARKit va gagner la capacité d'analyser les poses que prennent les gens et pour les jeux, iOS saura utiliser des contrôleurs dotés de pavés tactiles et des casques stéréo de réalité augmentée

Suivent une série d'améliorations en vrac :

Les développeurs pourront utiliser beaucoup plus de ressources du Taptic Engine pour les associer aux actions dans leurs apps.

Ils pourront inclure des prévisualisations de contenus comme le fait Messages avec des liens qu'on colle dans une conversation.

Pour la NFC, les développeurs pourront lire des tags de type ISO7816, le format des passeports et de certaines cartes sans contact (lire L'app du Brexit sera compatible avec l'iPhone d'ici la fin de l'année. Caressons le rêve de pouvoir remplacer encore plus de cartes par son iPhone…

Avec CoreML, les développeurs auront le moyen de voir leurs modèles d'apprentissage s'adapter aux actions de l'utilisateur, au fur et à mesure qu'ils se servent de leurs app. Au lieu que ces apprentissages soient définis en amont et figés. L'analyse intelligente de sons va rejoindre CoreML. Quant aux images, il ne sera plus nécessaire aux développeurs de créer leur propre solution pour reconnaître telle ou telle chose ou sujet devant la caméra, ce sera proposé par le système.

Autre mise à disposition des apps tierces, la fonction scanner de documents que l'on a actuellement dans Notes.

Une facilité supplémentaire : les apps auront le droit d'aller piocher dans le contenu d'une carte SD ou d'un appareil photo sans passer par l'app Photos d'iOS (et on s'épargnera des gymnastiques inutiles, lire Lightroom CC prend enfin en charge Raccourcis)

Sont citées des améliorations pour l'intégration de services tels que Dropbox dans le Finder et de nouvelles API pour la conception de pilotes de périphériques.

Enfin, Steve Troughton-Smith parle lui de nouveaux Animoji dans iOS 13 : une vache, une pieuvre, une souris et un visage avec l'allure d'un emoji