Vous avez dû le voir, les IA conversationnelles comme ChatGPT — la version 4 est arrivée récemment — demandent une très grande puissance de calcul lors de l'entraînement initial. Et surtout, le nombre de paramètres (175 milliards pour les modèles GPT-3) nécessite une quantité de mémoire très élevée. Pour ce type d'usage, Nvidia a donc annoncé la H100 NVL, en indiquant que cette génération est jusqu'à 12x plus rapide que la précédente sur les tâches liées à l'IA.

Une sorte de GPU mais sans sortie vidéo

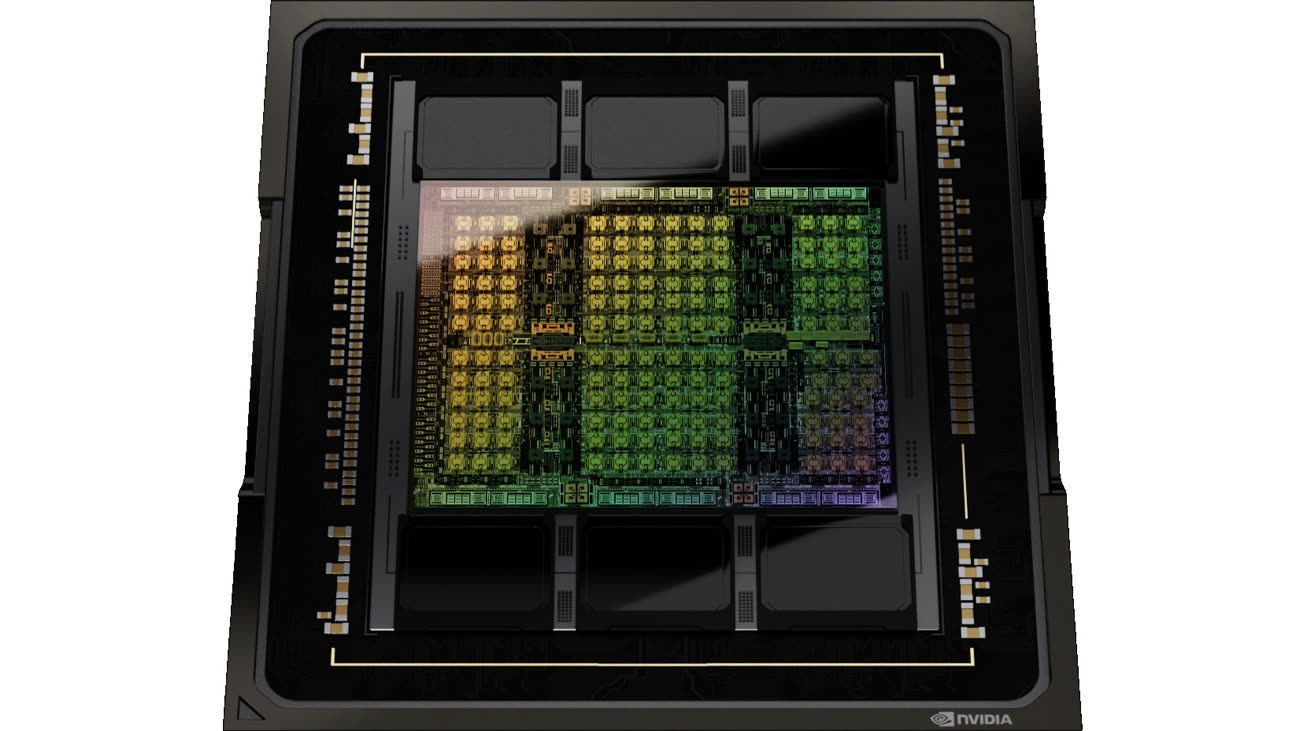

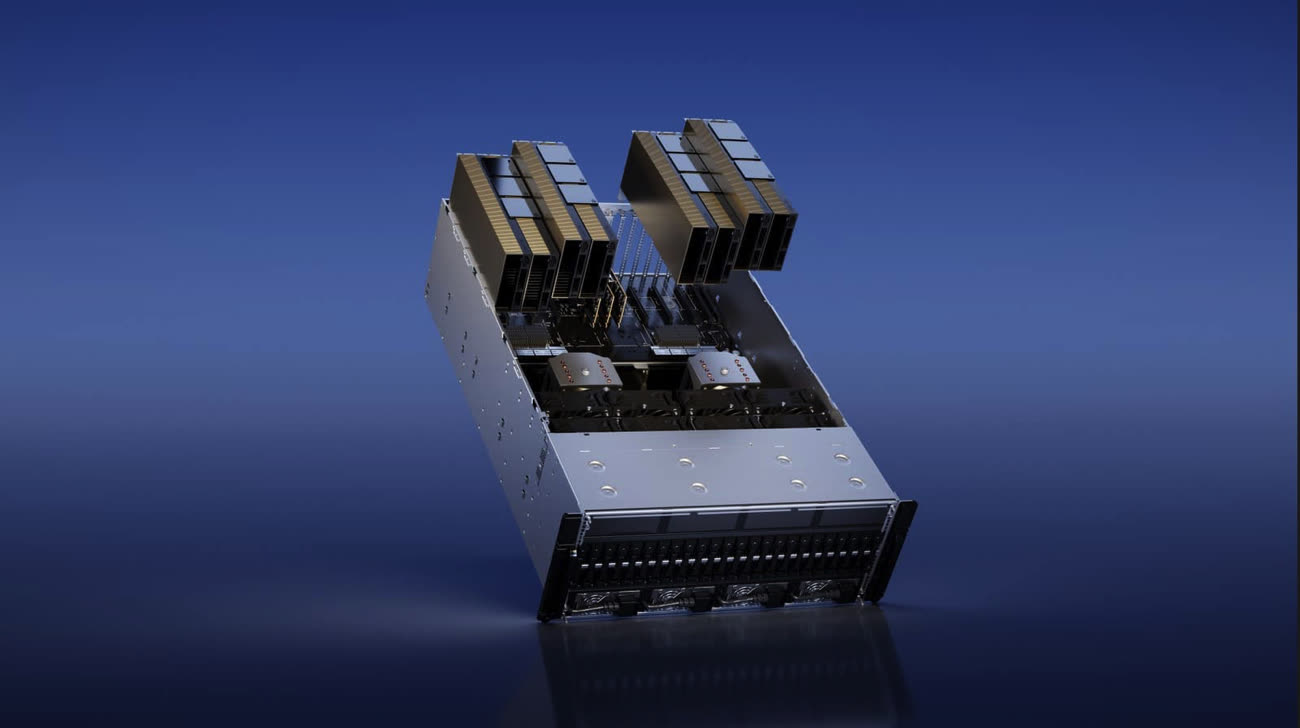

Techniquement, les cartes de la famille H100 sont des GPU, mais pensés uniquement pour du calcul, sans réelles possibilités d'affichage. La nouvelle carte est un véritable monstre : elle prend quatre emplacements (au sens physique du terme, c'est-à-dire la place de quatre cartes classiques) et nécessite deux emplacements PCI-Express, donc deux connecteurs. En effet, cette carte contient littéralement deux cartes PCI-Express reliées par la technologie NVLink 4, qui offre une bande passante de 600 Go/s.

Tous les détails ne sont pas connus, mais les GPU devraient utiliser la majorité des unités — donc 2x 16 896 — pour une puissance maximale de l'ordre de 135 téraflops (2x 67 téraflops). Elle impressionne surtout sur la mémoire : alors que les autres H100 sont bridées au niveau de la mémoire HBM3, cette version NVL propose (presque) le maximum possible.

188 Go de RAM

Les versions disponibles actuellement se limitent à 80 Go sur un bus 5 120 bits, avec une puce désactivée — sur les six possibles — pour augmenter le rendement. La H100 NVL, elle, contient 2x 94 Go de RAM sur un bus 6 144 bits, pour une bande passante de 3,9 To/s par carte. La raison de la perte de 2 Go sur le maximum théorique n'est pas connue, mais la valeur impressionne tout de même. Le lien NVLink 4 autorise l'unification de la mémoire du point de vue du logiciel, ce qui permet au système de voir une carte avec 188 Go de RAM au total, avec une bande passante cumulée de 7,8 To/s.

Le TDP des cartes est élevé et configurable, en fonction de la possibilité de refroidissement du serveur : 350 W ou 400 W par carte, donc jusqu'à 800 W au total.

Ce type de cartes vise évidemment un public très particulier, et si le prix n'est pas connu, il est probablement très élevé compte tenu des choix techniques. La version PCI-Express classique, dotée de 80 Go de RAM dans une variante deux fois moins rapide que la HBM3 choisie ici, se négocie par exemple aux alentours de 28 000 $. Notons enfin que les pénuries de GPU attendues à cause de l'essor des IA ne devraient pas se régler avec ce type de cartes, étant donné la cible et les prix attendus…

L'essor des IA pourrait créer une nouvelle pénurie de GPU