Les applications tirant parti des technologies d'OpenAI devraient se multiplier dans les prochaines semaines. L'entreprise vient d'annoncer le lancement d'API pour ChatGPT et Whisper, son moteur de transcription audio basé sur l'IA proposant des résultats très convaincants. Les développeurs tiers vont donc pouvoir facilement intégrer ces technologies dans leurs apps, le tout d'une manière moins couteuse qu'auparavant.

ChatGPT and Whisper are now available through our API (plus developer policy updates). We ❤️ developers: https://t.co/vpoyxZ7XnD

— OpenAI (@OpenAI) March 1, 2023

OpenAI explique avoir réussi à réduire les coûts de ChatGPT de 90 % depuis décembre grâce à un gros travail d'optimisation, ce qui lui permet de proposer un tarif plus abordable pour ses API. Celle-ci est déjà utilisée par certaines applications : Snapchat vient de lancer My AI, un chatbot réservé aux abonnés payants que l'on peut interroger sur tout et rien. La plateforme d'apprentissage Quizlet s'en est servie pour créer un « tuteur virtuel » avec lequel on pourra travailler, tandis que Shopify s'en sert pour un assistant de recommandation.

L'API se base sur « gpt-3.5-turbo », qu'OpenAI présente comme son meilleur modèle pour de nombreux cas d’utilisation hors chat. Son prix est de 0,002 $ par 1 000 tokens, ce qui est 10 fois moins cher que les modèles GPT-3.5 existants. Attention, car un token n'est pas égal à une requête : un outil permet de voir combien de ces crédits seront mangés par une seule phrase. Les plus gros consommateurs pourront demander une instance dédiée offrant des réglages plus précis.

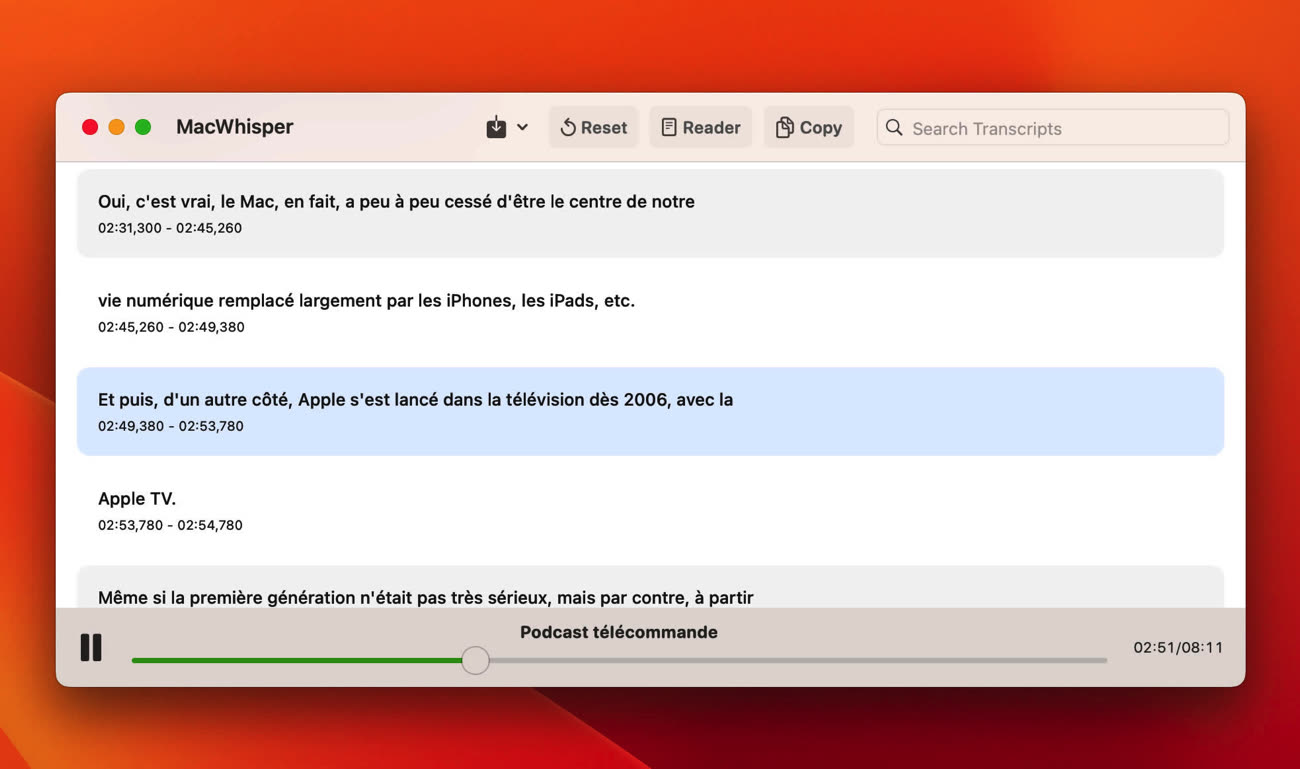

Les développeurs vont également pouvoir utiliser Whisper, le modèle de transcription audio étant facturé 0,006 $ la minute. S’il est open source (vous pouvez le faire tourner gratuitement sur votre Mac), passer par une API permettra aux entreprises de proposer des transcriptions rapides sur des appareils peu puissants. L'application iOS Speak utilise par exemple Whisper pour l'apprentissage des langues et l'entrainement à la conversation.

Enfin, OpenAI annonce avoir revu les conditions d'utilisation de ses API. Les requêtes envoyées ne sont plus utilisées pour entrainer les modèles, et les clients sont propriétaires des requêtes d'entrée et de sortie des modèles. La priorité des ingénieurs d'OpenAI est désormais la stabilité de ses services, et l'entreprise cherche à améliorer leur rapidité.